구글 클라우드 인스턴스 SSH에서 pyspark를 설치하고 jupyter notebook 실행 후 코드를 입력했는데 오류가 생겼다.

pyspark와 python의 버전이 맞지 않아 오류가 발생하는 것이었다.

python 버전을 변경하는 것보다 pyspark 버전을 바꾸는 것이 더 수월하므로 pyspark를 재설치한다.

* 현재 pyspark의 버전은 3.1.1이고, 3.5.1로 재설치할 것이다.

SSH에서 아래 코드를 입력하여 pyspark를 uninstall한다.

/opt$ pip uninstall pyspark

이후 opt 내 파일을 제거한다.

/opt$ sudo rm -rf *

명령어 ls를 통해 파일이 제거된 것을 확인할 수 있다.

/opt$ sudo wget -q https://dlcdn.apache.org/spark/spark-3.5.1/spark-3.5.1-bin-hadoop3.tgz위 코드를 통해 spark 3.5.1 버전을 다운로드 받는다.

/opt$ sudo tar -zxf spark-3.5.1-bin-hadoop3.tgz압축을 풀어준다.

파일이 생성된 것을 확인할 수 있다.

/opt$ sudo mkdir spark #spark 폴더 생성

/opt$ sudo mv spark-3.5.1-bin-hadoop3/* /opt/spark #spark-3.5.1-bin-hadoop3의 파일을 spark로 옮김

/opt$ cd spark

/opt/spark$ ls코드가 잘 실행됐다면 spark폴더에 아래와 같이 파일이 이동된 것을 확인할 수 있다.

pip install pyspark==3.5.1pyspark 버전에 맞춰 다시 설치를 진행한다.

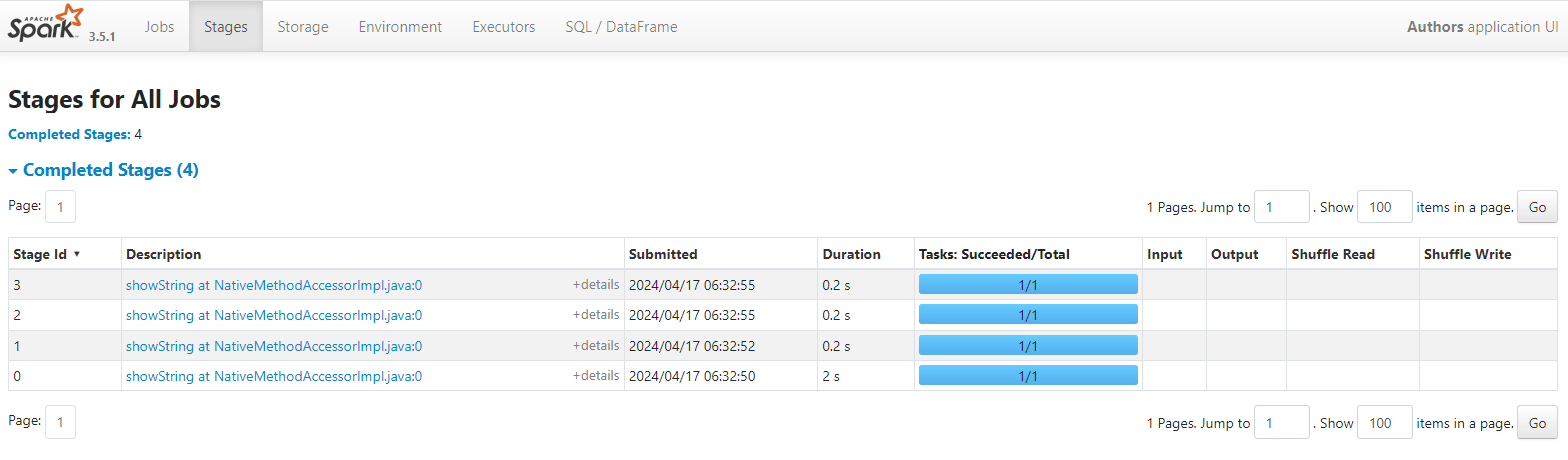

이후 jupyter notebook을 다시 열어 버전을 확인했다.

3.5.1 버전으로 설치가 된 것을 확인할 수 있다.

처음 오류가 났던 코드도 잘 실행되었다.

'Error' 카테고리의 다른 글

| git push 에러 (0) | 2024.01.30 |

|---|